- On April 13, 2024

- By mastilo403

Краулинговый бюджет: что это и как его оптимизировать Академия SEO СЕО

Важно не забыть настроить шаблоны для мета-тегов Юзабилити-тестирование для каждой страницы фильтрации на сайте. Термин «краулинг» был введен Google, поэтому когда оптимизаторы говорят о краулинговом бюджете, то в первую очередь имеют в виду деятельность поискового робота – Googlebot. Один из сотрудников Гугл, Гэри Илш, рассказал что любой сканируемый ботом линк повлияет на краулинговый лимит. Даже если оптимизатор укажет директиву, запрещающую сканирование. Рекомендуем прочесть полезную статью о том, какие обратные ссылки игнорирует Google.

Определение и особенности краулингового бюджета

Краулинговым спросом называется число страниц https://deveducation.com/ веб-ресурса, включенных в своеобразный «список планов» поисковых роботов по сканированию с целью дальнейшей индексации. О том, зачем и как правильно настроить sitemap.xml и robots.txt мы подробно рассказывали ранее. Тщательная и грамотная проработка этих файлов важна и для целей оптимизации расхода краулингаового бюджета веб-сайта. Роботы Google и Яндекса далеко не всегда четко следуют нашим указаниям, но часто ориентируются именно на них.

Рекомендуемые статьи этой категории

Рассмотрим основные и самые эффективные методы, позволяющие оптимизировать ресурс. Они положительно влияют на факторы, увеличивающие краулинговый бюджет, а также краулинговый бюджет помогают настроить взаимодействие с поисковыми ботами, а, следовательно, получить большую выгоду. После последнего апгрейда Гугла скорость загрузки страниц — один из важнейших факторов ранжирования. При хороших показателях увеличивается и продуктивность поискового краулера на сайте. То есть за одинаковое количество соединений бот сможет просканировать больше контента, чем если страница будет притормаживать.

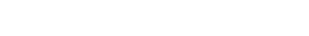

- Нужная информация находится на рисунке под названием «Количество сканированных страниц в день».

- Для этого существуют различные приемы, правильное применение которых помогает успешно контактировать с поисковыми роботами, превращая «общение» с ними в собственную выгоду.

- Робот в таком случае переключится на обновленные данные, которые необходимо отправить в индекс поисковика.

- Поисковик определяет для каждого сайта определенный лимит сканирования.

- Обращаем внимание, что лимит может увеличиваться при наличии качественной оптимизации ресурса, что положительно скажется на результатах сканирования поисковыми ботами.

- В противном случае, нужно более детально поработать с фильтрацией на сайте.

От чего зависят позиции сайта в Google и как проверить рейтинг страниц

В этих документах содержатся инструкции для поисковых ботов, как сканировать и индексировать содержимое сайта. Поэтому в robots.txt необходимо закрыть контент, который не приносит пользы и мешает положительному ранжированию. Из карты сайта необходимо удалить ссылки с редиректами, canonical. На сайте находится много категорий и подкатегорий продуктов, большое количество фильтров для удобства поиска. Важно, чтобы в индекс попадали страницы с высокомаржинальными товарами, которые приносят основную прибыль компании. Описанная выше первичная оптимизация подойдет, если проект оптимизируется с нуля или только небольшое количество неэффективных комбинаций попали в индекс.

Как привлечь внимание покупателей к онлайн-рекламе

А именно там может содержаться важный контент, который привлечет клиентов на сайт. К тому же, в выдачу могут попасть «мусорные» страницы, не приносящие бизнесу никакого профита. Допустим, «движок» ресурса генерирует большое количество «мусорных» ссылок, попадающих в карту сайта (sitemap), а затем и в индекс.

Поэтому своевременное закрытие «лишних» страниц позволит исключить их из списка сканирования, а открытие важных URL поможет роботам не пройти мимо. Краулинговый бюджет — это максимальное число страниц ресурса, со сканированием которых боты поисковика способны справиться за конкретный отрезок времени. Про краулинг сайта известно, что это процесс считывания, также называемого сканированием, страниц ресурса пауками поисковиков с целью сбора информации для последующей индексации. В этой связи seo-специалисты оперируют двумя похожими взаимосвязанными терминами — краулинговый бюджет и краулинговый спрос.

В этой статье разберемся, что такое краулинговый бюджет, почему он важен для сайта и что делать, чтобы сэкономить лимит и качественно оптимизировать ресурс. Итак, мы имеем возможность, а, значит, должны влиять на процесс взаимодействия собственного ресурса с поисковыми системами. Для этого существуют различные приемы, правильное применение которых помогает успешно контактировать с поисковыми роботами, превращая «общение» с ними в собственную выгоду. Используя все возможности, чтобы повлиять на рост краулингового бюджета сайта и добиться его оптимального расходования, можно положительно повлиять на индексацию и продвижение ресурса.

Именно это число бот может проиндексировать в сутки, то есть краулинговый бюджет сайта. Кроме того, слишком длинные цепочки вообще могут привести к тому, что робот не дойдёт до конечного URL. Во избежание всех этих неприятностей следует чистить ресурс от больших цепочек редиректов.

Это исключает двойное сканирование контента, который не менялся с тех пор, как поисковой бот сканировал страницу в последний раз. Робот в таком случае переключится на обновленные данные, которые необходимо отправить в индекс поисковика. Нужная информация находится на рисунке под названием «Количество сканированных страниц в день».

А это все — неэффективный контент, который может в любую секунду попасть в индекс вместо содержимого, которое принесет бизнесу необходимую пользу. Поэтому важно знать краулинговый бюджет сайта, чтобы не допустить подобной ситуации и увеличить эффективность сканирования ботов Гугла. А краулинговый бюджет — это лимит сканирования страниц, который выделяет поисковая система для каждого сайта. То есть, это ограниченное количество контента, индексируемое роботом в определенный временной отрезок. Итак, почему так важно SEO-оптимизатору знать краулинговый бюджет сайта? Если поисковой краулер при сканировании не сможет проиндексировать определенные страницы ресурса, то они просто выпадут из индекса.

В противном случае, нужно более детально поработать с фильтрацией на сайте. Для этого определяются кластеры, которые не приносят должного профита. Ссылки, приводящие к несуществующим страницам или документам, в результате чего может выскакивать ошибка 404, способны отпугнуть пользователей. Вместе с тем они негативно влияют на поведенческие факторы и мешают нормальной работе поисковых ботов. Это технология, которая используется для ускорения сканирования и индексации контента JavaScript- страниц. Метод позволяет предоставить краулеру поисковика версию с html-кодом, а пользователь при этом видит обычный вариант страницы.

Либо возможна такая ситуация, когда на сайте установлено много фильтров. За счет этого формируется большое количество различных комбинаций. Чтобы посмотреть, какое число страниц генерируется благодаря этому, возьмем, к примеру, страницу интернет-магазина косметики и парфюмерии «Кремы для лица и тела». Оптимизаторы часто не уделяют должного внимания такой важной вещи, как краулинговый бюджет. Если продвигается лендинг или небольшой сайт до 10 страниц, то беспокоиться не о чем, но если это крупный онлайн-магазин, тогда рекомендуем наш материал к прочтению.